简介

DX-M1 AI加速器M.2模块是一款采用标准M.2接口的高性能AI加速器模块,将服务器级的25 TOPS INT8推理算力带入边缘端。以仅2-5瓦的超低功耗运行,板载4GB LPDDR5内存,完美兼容x86与ARM架构平台,包括树莓派5、LattePanda等流行单板计算机。通过提供完整的DXNN® SDK工具链,支持PyTorch、ONNX、TensorFlow等主流框架模型的快速部署,极大降低了在智能机器人、工业视觉、自动驾驶及视频分析等场景中实现高效AI应用的门槛。

服务器级性能,边缘端低功耗运行

DX-M1 AI加速器M.2模块提供高达25 TOPS的INT8计算性能,足以流畅运行复杂的视觉识别、自然语言处理等深度学习模型。其创新之处在于实现了性能与功耗的绝佳平衡,典型功耗仅为2-5瓦,解决了边缘设备对高算力和低功耗的双重需求。使得设备在严苛的现场环境中也能保持稳定可靠的AI推理能力,无需依赖云端,保障了数据隐私和实时性。

标准接口广泛兼容,即插即用快速集成

采用全球通用的M.2 M-Key接口(2280尺寸)和PCIe Gen3 x4协议(兼容x1模式),DX-M1具备出色的平台适应性。无论是基于x86的工业电脑、NUC,还是基于ARM架构的树莓派5、LattePanda等开发板,用户均可通过熟悉的M.2插槽轻松安装,实现“即插即用”的AI能力升级,大幅缩短了硬件集成周期。

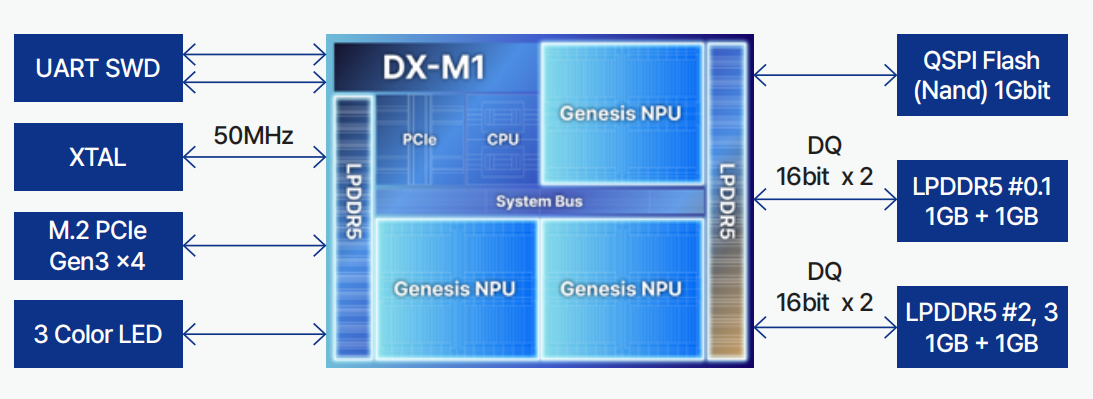

DX-M1 芯片核心架构与外设接口示意图

DX-M1 芯片核心架构与外设接口示意图完整工具链支持,简化模型部署全流程

配套的DXNN® SDK提供从模型转换、优化到运行时管理的全流程工具。支持PyTorch、ONNX、TensorFlow、TensorFlow Lite、Keras等多种训练框架,开发者可将已有模型快速编译并优化,高效部署到DX-M1上运行。这套工具链有效解决了不同框架模型在边缘设备上的移植难题,降低了AI应用开发的工程复杂度。

工业级可靠性,适应严苛工作环境

DX-M1的设计遵循工业标准,支持-25°C至85°C的宽温工作范围(25°C至65°C无降频),能够胜任工业现场、户外安防等对温度要求较高的应用场景。其坚固的硬件设计和稳定的驱动支持,确保了在连续运行条件下的长期可靠性,满足OEM厂商和系统集成商对产品品质的严格要求。

应用场景

- 智能机器人: 为服务机器人、AGV小车提供实时的视觉SLAM、障碍物识别和路径规划能力。

- 工业视觉: 在生产线上实现高速、高精度的零件质检、缺陷检测和生产安全监控。

- 智能安防: 在NVR或边缘视频分析盒中实现多人脸识别、车辆属性分析、视频结构化处理。

- 无人设备: 赋能无人机和自动驾驶平台,进行实时环境感知和决策。

特性

- 强大性能:25 TOPS INT8 AI推理算力

- 超低功耗:典型功耗2W - 5W

- 标准接口:M.2 M-Key (2280尺寸),兼容PCIe Gen3 x4 (支持x1模式)

- 板载内存:4GB LPDDR5 + 1Tbit QSPI NAND Flash

- 广泛兼容:支持x86与ARM架构,完美适配树莓派5/LattePanda

- 框架支持:PyTorch, ONNX, TensorFlow, TensorFlow Lite, Keras, XGBoost

- 操作系统:Windows 10/11, Ubuntu 20.04/22.04 LTS

- 高效部署:提供完整的DXNN® SDK,涵盖编译、优化、运行时全流程

- 工业级可靠:工作温度范围-25°C ~ 85°C

技术规格

- 处理器性能:25 TOPS (INT8)

- 接口:M.2 M-Key, PCI Express Gen3 x4 (兼容x1模式)

- 内存:4GB LPDDR5,1Tbit QSPI NAND Flash

- 功耗:2W ~5W

- 电源范围:3.3V±5%

- 框架支持:PyTorch, ONNX, TensorFlow, TensorFlow Lite, Keras, XGBoost

- 操作系统:Windows 10/11, Ubuntu 20.04/22.04 LTS

- 工作温度:-25°C ~ 85°C (可降频);25°C ~ 65°C (无降频)

- 产品尺寸:22 mm x 80 mm x 4.1 mm

documentstart

相关文档

documentsend

配送清单